开云体育

开云体育DeepSeek技术创新揭秘:人工智能领域的颠覆者

在全球人工智能技术迅猛发展的背景下,中国初创企业DeepSeek正在以其一系列创新的技术成果重塑科技竞争格局。随着大型语言模型(LLM)的广泛应用与普及,DeepSeek推出的推理模型展现了卓越的性能,训练成本却显著低于行业水平,引起了产业与学术界的广泛关注。本文将深入分析DeepSeek的三项代表性技术成果,分别是DeepSeek-R1、DeepSeek-V3以及DeepSeek-LLM,全面阐述它们如何在提升语言模型推理能力、优化模型架构与训练效率、推动开源语言模型发展等方面取得创新突破,并探讨这些技术对全球人工智能领域的重要影响与贡献。

在人工智能这个风口浪尖上,DeepSeek以其领先的技术及理念吸引了众多视线。尤其是其在核心领域的技术积累与多篇具有开创性意义的学术论文,为其后续的技术创新奠定了坚实的基础。通过对DeepSeek最为关键的三篇论文进行重点分析,本文旨在揭示DeepSeek的技术创新、应用效果、潜在局限性以及未来发展方向。

在大型语言模型的研究和应用中,推理能力是评价其性能的关键指标。而传统的监督微调方法在数据需求和效率上存在一定的瓶颈,DeepSeek-R1的目标便是通过强化学习全新方法来提升LLM的推理能力。

DeepSeek-R1-Zero采用了GroupRelativePolicyOptimization (GRPO)算法,通过群体奖励机制优化模型,在训练过程中引入了准确性奖励和格式奖励,确保模型能自主学习有效的推理行为。结合冷启动数据引导初期训练,DeepSeek-R1不仅提高了推理能力,还显著改善了对复杂任务的解答能力。

在多个数学推理任务中,DeepSeek-R1取得了与OpenAI模型相似的表现,尤其是在中文任务中,展现出独特的优势。这一成果标志着强化学习在语言模型优化新路径的开辟。

尽管在多语言处理上存在一定局限,但未来DeepSeek将致力于探索强化学习在全球应用中的更广泛落地潜力。

面对日益增长的大语言模型计算成本,DeepSeek-V3作为混合专家(MoE)模型应运而生,以6710亿参数的设定,将每个token的计算费用降至最低,并与顶尖闭源模型竞争。

通过引入低秩联合压缩方法和动态路由调整,DeepSeek-V3在保持性能的同时有效降低了计算资源消耗。此外,模型的最大上下文扩展至128K,使其能够处理更长的文档数据,提升了实际应用的适用范围。

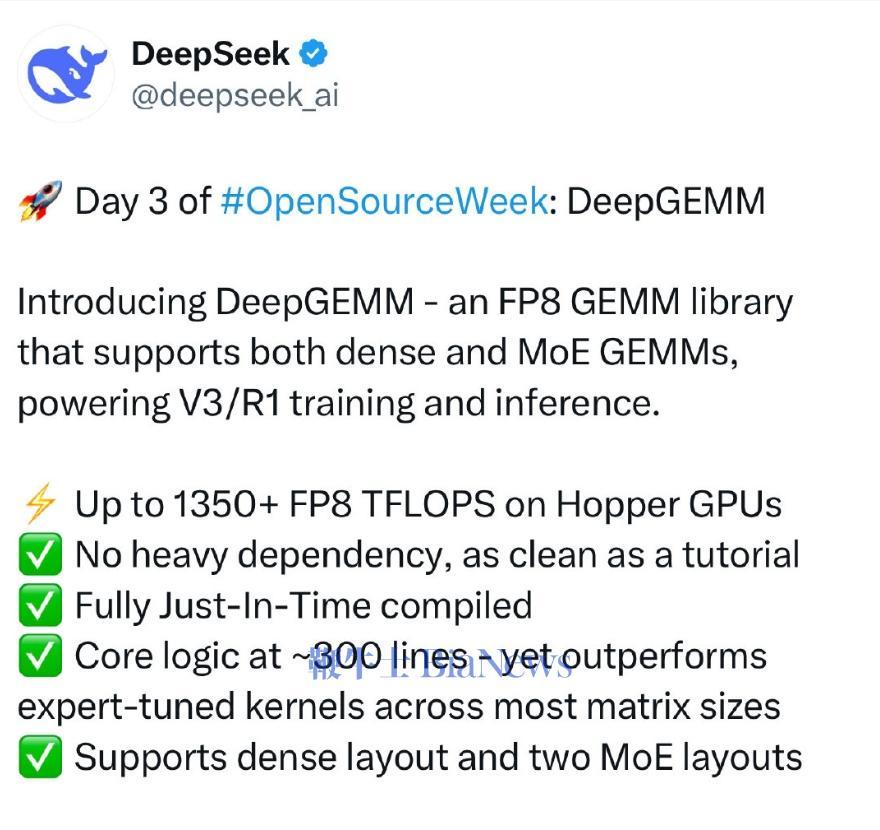

DeepSeek-V3使用的DualPipe算法和FP8混合精度训练显著提高了训练效率,为模型的高效推理和部署打下基础。

深度探讨模型规模与数据分配的长期规律,DeepSeek-LLM旨在推动开源模型的可持续发展,特别是为基础模型的进一步优化提供科学依据。

DeepSeek-LLM处理了庞大的双语数据集,采用RMSNorm、SwiGLU等顶尖技术确保了模型架构的高效性。基于现代化的超参数优化,构建了一套高效训练框架,以期在算力利用率上达成最佳效果。

DeepSeek-LLM在多个公共基准测试中均超越了现有先进模型,展现了卓越的中文推理与文本生成能力。

DeepSeek的三项关键技术成果在全球人工智能领域引发了深远影响,通过减少对监督数据的依赖,推动高效推理、经济节省与开源语言模型的快速发展,促进领域的民主化进程。尽管如此,深层次的挑战依然存在,特别是在数据隐私与安全等方面,需要持续优化与探索。

展望未来,DeepSeek将在技术、应用和国际竞争中继续引领,推动人工智能的智能化转型。通过不断的技术创新与跨领域结合,将为未来的技术发展和人类社会的进步贡献更多力量。返回搜狐,查看更多

2025-07-08

2025-07-08 浏览次数:

次

浏览次数:

次 返回列表

返回列表